俄研发杀人机器人 千里之外可追踪并击杀

随着人工智能的发展,“杀人机器人”成为全球普遍担心的问题,各国都禁止研发“杀人机器人”是否能迎来世界和平,也成为人们讨论的内容。但是,现在已经有国家研制出了此类机器人。

据外媒报道,俄罗斯研发了一种名叫“Flight”的机器人,它可以侦测和跟踪4英里(约6.4千米)外的目标。

Flight是为保护俄罗斯边境而设计的,该国计划将它和爆炸系统结合起来使用,准确检测和攻击地面和空中的威胁,在它们远未进入俄罗斯领土和领空之前就消除它们。以下为原文内容:

Flight机器人的关键技术包括雷达、高清成像和热成像系统,以及多个远程榴弹发射装置。

这种机器人配备了一系列先进的监视工具,可以发现6英里(约10千米)以外的潜在入侵者,比如车辆、低空飞行的无人机等等。

目前以监控和侦测为主

俄罗斯工程师声称它可以为远程爆炸武器选择目标。但它的主要用途是监控。这种机器人不仅可以监测正在靠近的无人机的精确位置,还可以查出它们来自哪里,甚至可以跟踪它们穿过天空的运动弧线。

随着莫斯科和西方之间的紧张局势持续升级,这种机器人可以帮助俄罗斯更好地发现西方间谍机构派遣到该国领空的监视飞机。

该项目首席工程师Dmitry Perminov对俄罗斯新闻媒体说:“Flight机器人配备了一个用来侦测目标的雷达单元,可以侦测到7千米之外的人类,10千米之外的车辆。在侦测到目标之后,它就使用光学系统来跟踪它们。”

Flight项目主管Leo Nosenko表示,该团队已经就如何与军方开展测试与莫斯科进行了讨论。军方尤其感兴趣的是,Flight机器人如何与远程导弹或火炮系统配合使用,在数英里之外以前所未有的准确性轰炸目标。

如何与爆炸系统结合使用?

Perminov声称,Flight将持续改善和升级,以后它可以在没有人类监督的情况下满负荷运行。而它的终极目标是100%准确地区分敌军和盟军。

武器专家还在研究如何让高科技爆炸系统与Flight监视机器人协同工作。

Perminov对俄罗斯新闻媒体说,“我们感兴趣的不仅仅是侦测无人机,而且还要将它们击落。”

这种作战模块可以安装在俄罗斯边境的安全塔上。在控制室里,一个操作员可以同时控制最多16个发射装置。

战斗机器人搭载的热成像软件可以找到目标,然后对250米以内的目标进行打击,目前来说,在任何弹药发射之前,操作者必须先确认目标是敌人,而不是平民或者盟友。

武器专家还在研究一种代号为“阿尔法装置”(Alpha Device)的高科技爆炸系统,以便和Flight监视机器人协同工作。阿尔法装置拥有几个榴弹发射装置,射程为400米。

俄罗斯军方希望有一天Flight机器人与阿尔法设备可以结合起来使用,成为全球最强大的边境保护系统之一。

如何阻止杀人机器人?

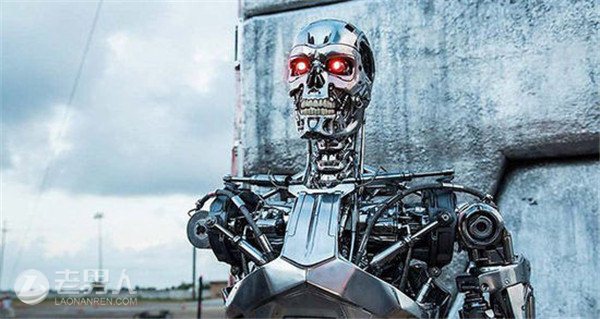

如果你问问周围的人,什么是“杀人机器人”,他们可能会提到《终结者》之类的作品。自主杀人机器让人感到恐惧。一些机构正在力图阻止这种机器人的出现。

但纽约州立大学的研究人员表示,这种努力意义不大,因为问题不在杀人机器人本身,而在于社会(特别是五角大楼这样的军事机构)如何研发暴力机器人。

研究人员说:“我们不应该妖魔化杀人机器人,而且应该去了解创建、支持和验证这些机器人的工具、流程和操作程序。”

参与了这项研究的教授特洛·卡普皮(Tero Karppi)表示:“我们必须将‘ 杀人机器人’这个词解构为更小的文化技术。”

这意味着我们不应该只注意杀人机器人是什么,它们可以做什么,也要把注意力放在它们的开发上。

“我们需要倒回去看看机器学习、模式识别和预测建模的历史,以及这些东西是如何设计出来的,” 卡普皮说。

当把机器人用在战场上时,你需要机器人能够区分朋友和敌人,但敌人和朋友之间的界限有些时候非常模糊。所以卡普皮觉得,我们需要研究规则和伦理是如何转化为软件编码的。

“战斗人员和非战斗人员、人类和机器、生命和死亡之间的区别并不是由机器人来定义的。虽然拉动扳机的可能是机器人,但这个实际操作是一系列的操作、过程和计算的结果。”

他的意思是说,人们对AI的关注应该落脚在开发人员身上,而不是技术本身上面。

“禁止杀人机器人运动”的主张

对于如何界定和规范自主武器,学术界和一些非政府组织(NGO)的看法莫衷一是。

2012年,一个NGO开始开展“禁止杀人机器人运动”。这几年来,我们已经看到过机器人在战争、执法、意外事故中导致过人类或动物死亡。这些机器人并不总是邪恶的——有些是被用来杀死入侵物种,保护湖泊和河流。但“禁止杀人机器人运动”反对的是自主杀戮的机器人,目标是禁止那些完全自主行动的武器。

活动者认为,让机器来做出生或者死的决定,这跨越了基本的道德底线。自主机器人缺乏人类的判断力,不能像人类那样理解上下文。在瞬息万变的战场上,战士面临着复杂的伦理选择,他们要区分士兵和平民,评估攻击的必要性。但完全自主的武器没有这个能力,不符合战争法的要求。

前面提到过,卡普皮认为,人们在为自主武器系统编写代码时,就已经注入了道德决定——“人类设计的这些系统,是在人类的环境中与人类一起开展行动,所以什么时候人类没有参与行动呢?”

几个月前,达拉斯警方曾遥控机器人杀死过一名犯罪嫌疑犯,但这种机器人并不是“禁止杀人机器人运动”针对的目标,因为它是由人类远程控制的。随着技术的进步和机器人的普及,对“自主性”这个词进行明确的界定也变得越来越重要。目前广泛被人们接受的定义是:自主机器人是那种可以在没有人类控制的情况下执行任务的机器人。不过一些学者也提出了略有差异的定义。

除此之外,还有更多的问题需要考虑。“禁止杀人机器人运动”的协调员玛丽·沃尔汉姆(Mary Wareham)表示:“完全自主武器所带来的巨大的、多方面的挑战可能会吸引学者在学术上做出回答,但这种回答在现实世界中没有太大用处。对于一些现在不可能做到的事情,例如将伦理注入到软件编码中,一些研究者似乎抱有太大的信心。如果我们要对武器系统(特别是其瞄准和攻击功能)进行卓有成效的控制,需要的是制定法律和政策。”

不管怎么说,这都是一个重大议题。无论你倾向于哪种观点,随着这种技术的迅速发展,我们都将在不久的将来看到这种辩论的再度延伸。

![>新时达机器人蔡亮 [专访]新时达蔡亮:内资机器人需沉稳前行 数年内有望掌握全球话语权](https://pic.bilezu.com/upload/6/6e/66e28d9b50444b04f7ab9b38e09553c3_thumb.jpg)