小学生直播拍到妈妈洗澡 抖音平台该负有怎样责任?

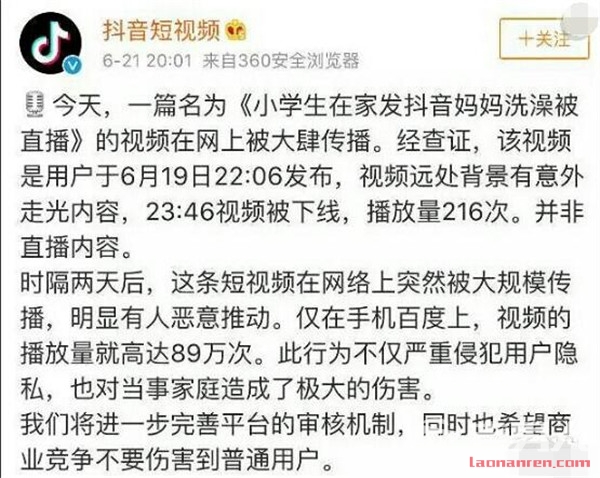

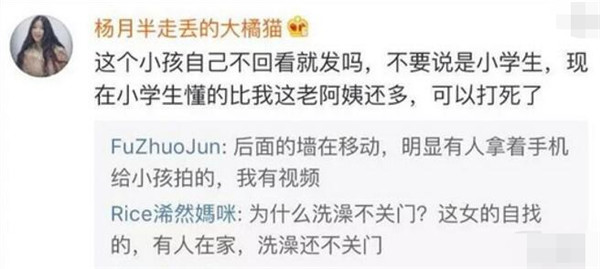

近日,一段名为“小学生在家发抖音妈妈洗澡被直播”的视频在网上传播。据了解,该视频是用户于6月19日22时6分发布,视频远处背景有意外走光内容。23时46分,该视频被下线,播放量216次。

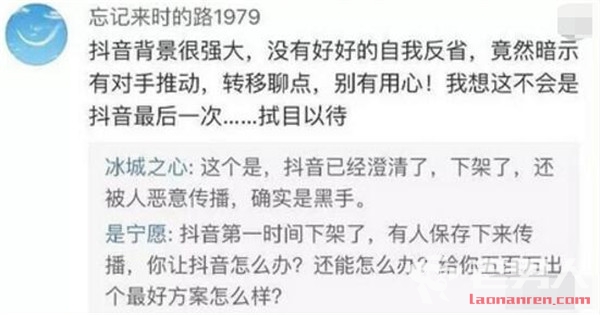

抖音对此回应称,这条短视频在网络上突然被大规模传播,明显有人恶意推动。此行为不仅严重侵犯用户隐私,也对当事家庭造成了极大的伤害。抖音将进一步完善平台的审核机制,同时也希望商业竞争不要伤害到普通用户。

记者了解到,类似“意外走光”的视频在短视频平台上并不鲜见,就在近日,还曾出现类似的“女孩镜子前录抖音拍到后面妹子换衣服”等视频。为何此类视频可以通过审核发布出来?

短视频平台难辞其咎

这类视频被发布出来后,有人认为抖音难辞其咎,应该负审核不力的责任。反对者则认为,抖音已经下架了原视频,但被其他人保存并传播,似乎也无计可施。

对此,中国传媒大学广告学院教授冯丙奇认为,此事中有三方负有责任,分别是抖音、视频发布者、抖音用户(小学生的家长)。无论是否是有人恶意传播,如果视频源自抖音,抖音负有审核责任;看到有不当内容仍然有意散播者,也负有明显的责任,至少是社会性的责任;小学生家长本应该强化类似个人账户的管理,避免没有恰当独立判断力的儿童在没有监管情况下随意使用。

在中国传媒大学文法学部法律系副主任郑宁看来,侵权责任法第三十六条对此有明确规定,网络用户、网络服务提供者利用网络侵害他人民事权益的,应当承担侵权责任;网络用户利用网络服务实施侵权行为的,被侵权人有权通知网络服务提供者采取删除、屏蔽、断开链接等必要措施。网络服务提供者接到通知后未及时采取必要措施的,对损害的扩大部分与该网络用户承担连带责任;网络服务提供者知道网络用户利用其网络服务侵害他人民事权益,未采取必要措施的,与该网络用户承担连带责任。

“因此,根据侵权责任法,网络服务提供者,在符合法定情形的条件下需要对侵犯他人民事权利的行为承担连带责任。”郑宁说。

郑宁告诉记者,《最高人民法院关于审理利用信息网络侵害人身权益民事纠纷案件适用法律若干问题的规定》第九条规定:人民法院依据侵权责任法第三十六条第三款认定网络服务提供者是否“知道”,应当综合考虑下列因素:网络服务提供者是否以人工或者自动方式对侵权网络信息以推荐、排名、选择、编辑、整理、修改等方式作出处理;网络服务提供者应当具备的管理信息的能力,以及所提供服务的性质、方式及其引发侵权的可能性大小;该网络信息侵害人身权益的类型及明显程度;该网络信息的社会影响程度或者一定时间内的浏览量;网络服务提供者采取预防侵权措施的技术可能性及其是否采取了相应的合理措施;网络服务提供者是否针对同一网络用户的重复侵权行为或者同一侵权信息采取了相应的合理措施;与本案相关的其他因素。

事前审核有何难度

短视频行业在近两年呈爆炸式发展,不仅用户的观看习惯愈发成熟,出现了更多内容创作者,各平台、机构、广告主也纷纷加入其中。

据卡思数据显示:去年短视频总播放量以平均每月10%的速度增长,在更节目的平均增速已达到每月16%,预计2018年短视频的广告规模将达到百亿。

有业内人士认为,短视频覆盖范围的极速扩张,对社会的影响力也越来越大,平台在满足用户观看、创作、沟通等需求的同时,也应对平台内视频负有监管责任,引导用户形成正确价值观,这就愈发显现出视频审核工作的重要性。

然而,记者尝试使用短视频平台发现,拍摄后就可以直接发布视频,没有看到审核过程,有一些违规视频也是事后删除处理。

对此,郑宁说,据她了解,目前短视频平台的审核基本是智能和人工相结合,但审核机制略有不同,如有的平台的视频时长只有10秒,用户上传后,会自动将视频切成图片,可能是10至100张,然后审核人员一眼就能审核完毕,但还是会采取先发布后审核的策略,后期如果审核不通过,就会删除,合理的举报机制也会有帮助。

发布短视频是否需要事先审核?事先审核是否存在难度

“事先审核机制能降低违法风险,但事先审核机制的建立需要具有较为强大的技术支持。”郑宁说,先进的技术加上人工判断的成本,如果经过论证,认为事先审核机制收益大于成本,则可以考虑采取。但是指望事先审核过的视频不出任何问题,也是不现实的,毕竟违法手段多样、隐蔽,而且信息海量。

在冯丙奇看来,内容的事先审核机制本身就存在难度,尤其是对视频内容的审核,难度更大。有效又务实的审核方法是:事后追惩机制与事先审核机制整合,视频内容审核与用户内容发布历史性监管相整合。

明确责任加强审核

“视频平台不当内容的‘公然传播’,是审核不力与有意放水两者的综合结果。前者表明视频平台视频审核的力度与方法有问题,后者则是视频平台为了获取公众关注度(即市场)有意置之不理的问题。就像刚才说的,应当把视频平台的视频发布历史作为主管机构的监管考量因素。”冯丙奇直言。

在郑宁看来,平台首先要完善视频审核流程,将机器审核与人工审核相结合,提高机器审核的准确度,完善人工审核标准和流程,机器审核初步过滤标题、内容中的关键词,人工审核内容的封面内容;其次,平台应建立举报机制,为用户提供举报途径,有利于扩大平台监管力度,提高监管效率;再次,平台应对短期内传播迅速的视频进行二次审核,针对涉黄视频短期内传播量迅速增加的特点,短视频平台应当建立监测机制,对短期内传播量异常增加的视频进行二次审核。

“最后,建立健全对视频发布者的认证与审查机制。为维持良好的网络环境,短视频平台应当建立视频发布者的认证机制,对于发布低俗、敏感、涉黄信息的用户建立黑名单,采取强化审核、严禁发布视频等措施,完善用户审查机制,避免出现利用新账号继续发布违法违规视频情形。”郑宁说。

郑宁说,如造成不良后果的平台应当承担的责任,分为民事责任、行政责任和刑事责任三种。

“民事责任是指违反侵权责任法第三十六条应受的处罚,而行政责任是指违反网络安全法、《互联网视听节目服务管理规定》《互联网等信息网络传播视听节目管理办法》《广播电视管理条例》《互联网直播服务管理规定》等相关规定所需承担的对应的处罚。”郑宁说。

“最严重的是刑事责任,刑法第二百八十六条规定了拒不履行网络安全管理义务罪,网络服务提供者不履行法律、行政法规规定的信息网络安全管理义务,经监管部门责令采取改正措施而拒不改正,有下列情形之一的,处三年以下有期徒刑、拘役或者管制,并处或者单处罚金:(一)致使违法信息大量传播的;(二)致使用户信息泄露,造成严重后果的;(三)致使刑事案件证据灭失,情节严重的;(四)有其他严重情节的。单位犯前款罪的,对单位判处罚金,并对其直接负责的主管人员和其他直接责任人员,依照前款的规定处罚;有前两款行为,同时构成其他犯罪的,依照处罚较重的规定定罪处罚。”郑宁说。